来源:阿牛智投

21-01-27 17:35

来源:阿牛智投

21-01-27 17:35

采用预训练语言模型的文本分类算法难以区分细粒度的语义信息,尚无法在金融量化投资领域获得成功应用。近日,瞰点科技与华东师范大学、哈佛大学、上海交通大学的研究人员合作,将论文发表在ACM CIKM2020上的面向量化投资的细粒度金融文本分类框架正式对外发布。该方法采用针对目标任务的全局和模块信息编码融合的思想,有效地提升了针对金融领域的细粒度文本分类精度。

文本分类任务(text classification)是指根据文本内容自动地将文本分配到预定义类别的过程,是自然语言处理最基本的任务。文本分类的应用很多,如新闻分类、情感识别等,并且能够为更复杂的语言理解任务提供基础,如意图识别、关系抽取、事件检测等。

金融领域的文本分类任务尤其引起关注,股票投资机构的研究者每日分析大量的与投研分析相关的文本,以此来把握行业动态、做出合理的投资决策。因此,准确地将每日产生的大量金融文本自动分到规定类别以供研究人员进一步研究十分必要。

尽管已有市场上已经涌现许多基于文本分类的应用,这些模型大多基于大型预训练语言模型,对于复杂的类别体系,往往采用增加训练数据的方式提高模型的效果。但是金融领域不同类别之间语义上十分相似,仅在金融概念上有所区别。现有模型处理这类文本分类时,面临以下几项挑战:

分类体系类别数量多。在真实的工业应用中,例如金融领域,分类体系往往是类别繁多的复杂体系,类别体系最下端的叶子类别往往只有较少的训练数据,通过增加训练数据提升分类效果的方法成本较高且效果不可控;我们服务于量化投资的分类体系涉及 500 多个类别,分别分布于 7 个层级中;

分类体系类别粒度细。金融领域文本分类的类别体系往往类别之间相关性很大,无法直接通过文本信息进行分类。例如在我们的分类体系中,宏观 - 行业栏目下的 C4.2.5.1 产业支持政策 与公司 - 经营活动栏目下的 H2.9.3 产品结构调整与 H2.9.4 业务转型存在较强的相关性;

分类涉及领域的知识。金融领域文本分类任务往往设计许多领域相关的知识,例如垂直领域的实体,这些实体对文本分类的结果起十分关键的作用,忽略这些实体信息而将其当作普通的文本叙述,导致分类效果难以提升。

因此,在本文中,瞰点科技联合华师、哈佛、交大等机构的研究者提出了一种名为 GraphSEAT 的文本分类框架,可以为中国顶级金融信息服务供应商提供金融文本分类服务。具体来讲,他们创建了用于建模目标金融文本全局结构的异构图,其中文本和金融命名实体被视为节点(node)。并且,利用边缘(edge)将文本连接到包含的命名实体,然后利用注意力机制训练图卷积网络(GCN)以学习包含文本域信息的嵌入表征。

此外,研究者利用神经序列编码器从文本的词序列中提取语义信息,并通过注意力机制融合文本学得的两个表征,最终形成了文本的整体嵌入表征并进行预测。

最后,研究者在自己发布的真实金融新闻数据集和其他 3 个公开数据集上进行大量实验,以评估 GraphSEAT 框架的性能。结果表明,该框架优于全部 8 个同类型的基准模型,特别是在研究者自己的数据集上。

论文地址:https://dl.acm.org/doi/10.1145/3340531.3412707

代码地址:https://github.com/finint/graphSEAT

模型和方法

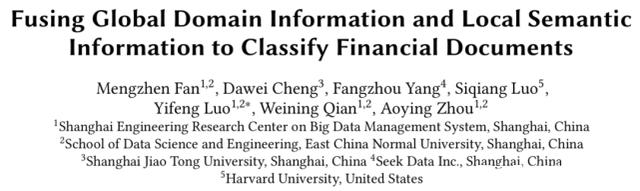

本文提出一种解决细粒度金融领域文本分类任务的方法 GraphSEAT :Fusing Global Domain Information and Local Semantic Information to Classify Financial Documents。模型结构如下图所示。模型主要包括三部分,分别是全局领域信息编码器、局部语义信息编码器和一个 Attention 模块。

模型结构图。

全局领域信息(Global Domain Information)编码器:本文使用金融领域的实体信息作为全局信息,例如公司、人名、地点、时间和产品等。研究者构建一个文本(document)和命名实体(entity)的异构图来建模全局领域信息,如果实体存在于文章中,那么该实体节点和该文章节点就在异构图的邻接矩阵中产生连接,那么不同的文章将通过异构图中的同一个实体联系起来。文章和文章之间、实体和实体之间的都存在着直接连接关系。

本文使用图卷积(GCN)来提取全领域信息,GCN 对于中心节点的每一个邻居的上一层的表征取平均作为当前的节点的表征,但在真实的金融文本中,不同的邻居节点对于文本的正确分类并不同等重要。因此,本文使用注意力机制动态地计算每一个邻居节点的权重。实体节点的初始化表征为词向量,文章节点的初始化表征为文本词向量的均值。

局部语义信息(Local Semantic Information)编码器:金融新闻除了金融领域有关的全局领域信息之外,最基本的语义是文本本身所包含的语义,本文称为局部语义信息。对于局部语义信息,本文采用双向的 GRU 作为编码器,并将正反向的表征合并,作为最终的结果。

在合并上述两部分信息作为文章的最终表征时,本文使用注意力机制,动态地计算每部分的权重。最后,将加权求和作为分类器的输入用于文本分类。

实验

本文在两类数据集上进行了实验,第一类是金融领域的文本数据集 FGCNews(Fine-Grained Chinese Financial News)。该数据集由瞰点科技与华师联合发布,并已由预训练好的命名实体识别模型识别出其中的实体。同时为了证明该模型的普适性,本文方法还在通用文本分类数据集(Movie Review、AGNews 和 Reuters 两个子数据集)上进行了广泛的验证。对于通用数据集,由于没有特殊的领域信息,本文使用词表作为全局领域信息。

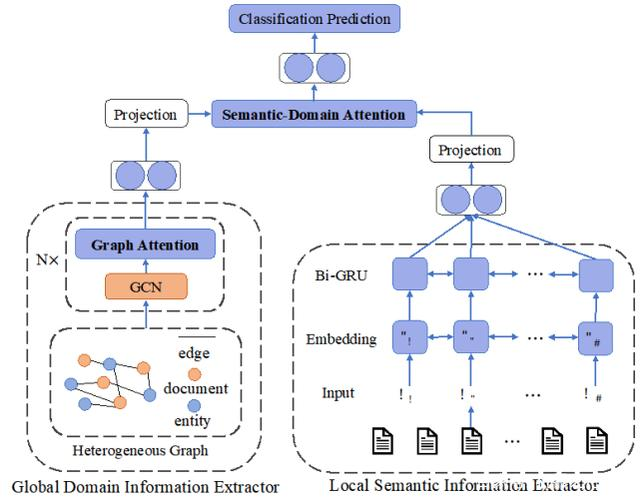

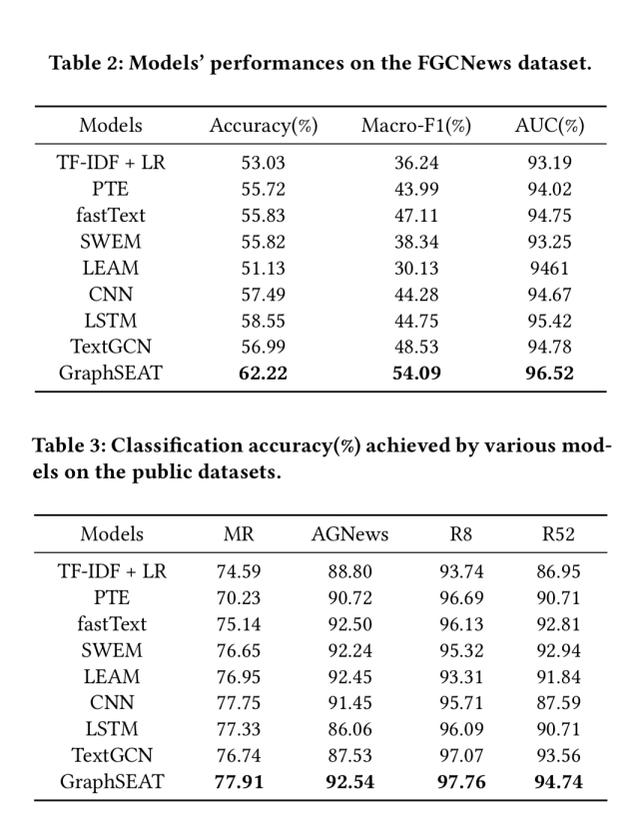

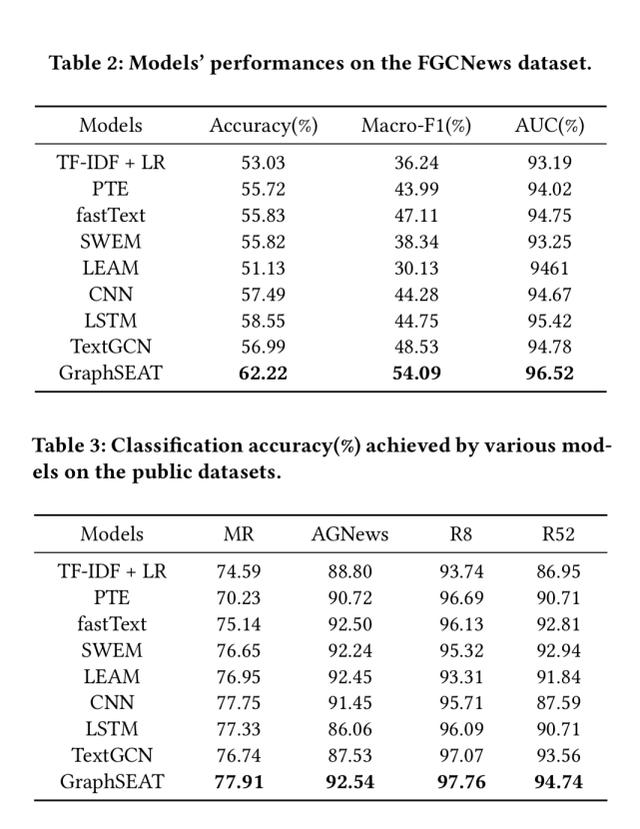

下表 2 和表 3 汇总了以上数据集在本文模型和对比方法上的实验结果:

实验结果表。

从表中可以看出,本文模型在文本分类任务上有着优于基线的效果,尤其在金融文本数据集 FGCNews 上。在通用文本分类数据集上,虽然全局信息编码器仅仅使用了词表信息,但是本文模型仍然比基本方法有一定的提升效果,验证了本文方法在细粒度分类任务中的有效性。

为了探究模型每一部分的效果,本文进行了控制变量实验,实验分别研究了消去局部文本信息编码器、消去全局领域信息编码器、消去异构图上的注意力机制、消去语义合并处的注意力机制以及同时消去两部分注意力机制的效果,实验效果如下表 4 所示:

表 4:控制变量实验结果。

未来展望

本文讨论了面向量化投资的金融领域细粒度文本分类任务,通过建立文本和命名实体的异构图,将实体这一领域特征信息加入文本表征,但是本文仍然留有以下工作可以探索:

1. 本文所识别的实体包含公司、产品、人物、地名等,但是本文在处理实体信息时将其视为一个整体的集合,实际上,实体类型包含了更丰富的领域知识;

2. 本文依赖上游预训练好的实体识别模型,不是一个端到端的训练任务,采用端到端的学习或多任务学习是本论文的一个未来研究方向。

瞰点科技 (www.seek-data.com) 是位于上海的金融高科技企业,主要研究知识图谱、自然语言处理等 AI 与大数据技术在量化投资领域的应用,并且上线和发布多款 AI 技术驱动的策略产品。在后续的研究中,研究者将会继续探讨和介绍自然语言处理服务于量化投资的创新算法。

参考文献

[1]. Yao, Liang, Chengsheng Mao, and Yuan Luo. "Graph convolutional networks for text classification." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 33. 2019.

[2]. PetarVelickovic, GuillemCucurull, ArantxaCasanova, AdrianaRomero, Pietro Lio, and Yoshua Bengio. 2017. Graph attention networks. arXiv preprint arXiv:1710.10903 (2017).

[3]. Linmei, Hu, et al. "Heterogeneous graph attention networks for semi-supervised short text classification." Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing (EMNLP-IJCNLP). 2019s

[4]. Lai, Siwei, et al. "Recurrent convolutional neural networks for text classification." Proceedings of the AAAI Conference on Artificial Intelligence. Vol. 29. No. 1. 2015.

[5]. Kipf, Thomas N., and Max Welling. "Semi-supervised classification with graph convolutional networks." arXiv preprint arXiv:1609.02907 (2016).

[6]. Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, ukasz Kaiser, and Illia Polosukhin. 2017. Attention is all you need. In NIPS. 5998–6008.

[7]. Joulin, Armand, et al. "Bag of tricks for efficient text classification." arXiv preprint arXiv:1607.01759 (2016).

[8]. Minaee, Shervin, et al. "Deep learning based text classification: A comprehensive review." arXiv preprint arXiv:2004.03705 (2020).

来源:机器之心Pro

扫一扫 下载APP

扫一扫 下载APP